Nel 1955, l’informatico statunitense John McCarthy coniò l’espressione “intelligenza artificiale” per proporre un gruppo di lavoro concentrato sulla modellazione matematica dei processi cognitivi umani attraverso l’uso dei computer. Fondò così un campo di studio di inimmaginabile portata, contribuendo con ricerche e attività incoronate nel 1971 con il Premio Turing, il più alto riconoscimento della comunità informatica, e celebrate a più riprese dall’Università di Stanford, in cui insegnava.

Qualche tempo fa, esisteva un sito personale di McCarthy: un blog senza elementi grafici né margini o tentativi di impaginazione, con trasudanti tracce di personalità che rimandavano ai suoi articoli in formato .ps .dvi .pdf. Navigare il suo sito era spassoso, per la possibilità di inciampare in commenti tipo: “I have decided to make some comment from time to time on world, national and scientific affairs. I don’t have time to make this into a proper blog”. Anche se qualcosa si è perso, la rete di articoli di McCarthy e buona parte dei suoi pensieri sono stati salvati dal JMC Project in un sito dedicato.

Quando parlava di robot e macchine intelligenti, John McCarthy escludeva l’eventualità che questi dovessero essere programmati per simulare emozioni. Una sua frase scritta nel 1995, in conclusione a un paper dal titolo Making Robots Conscious of their Mental States, recita come segue:

È importante evitare di progettare robot che siano bersagli di simpatia o antipatia umana. Se i robot sono visibilmente tristi, annoiati o arrabbiati, gli umani, a partire dai bambini, reagiranno a loro come persone. Allora molto probabilmente arriverebbero a occupare un certo posto nella società umana. La società umana è già abbastanza complicata.

Oggi possiamo contraddire questo pensiero per vari motivi. McCarthy stesso confessava che certi suoi colleghi ragionassero diversamente, ma il punto è che negli anni ’90 sopravviveva, ignara del domani anche nell’informatico più visionario, l’opportunità di disquisire circa la convenienza che macchine, preposte per interagire con gli uomini, potessero simulare emozioni. Non avevano la più pallida idea di come ci saremmo trasformati, di come la nostra società sarebbe diventata pervasiva con il tessuto digitale attraverso dispositivi portatili, assistenti vocali, interfacce deumanizzate e altre cose che non voglio elencare, perché sapete in che mondo viviamo e su cosa si sorregge la nostra nuova condizione umana.

Il ruolo delle macchine e dei robot nella società umana

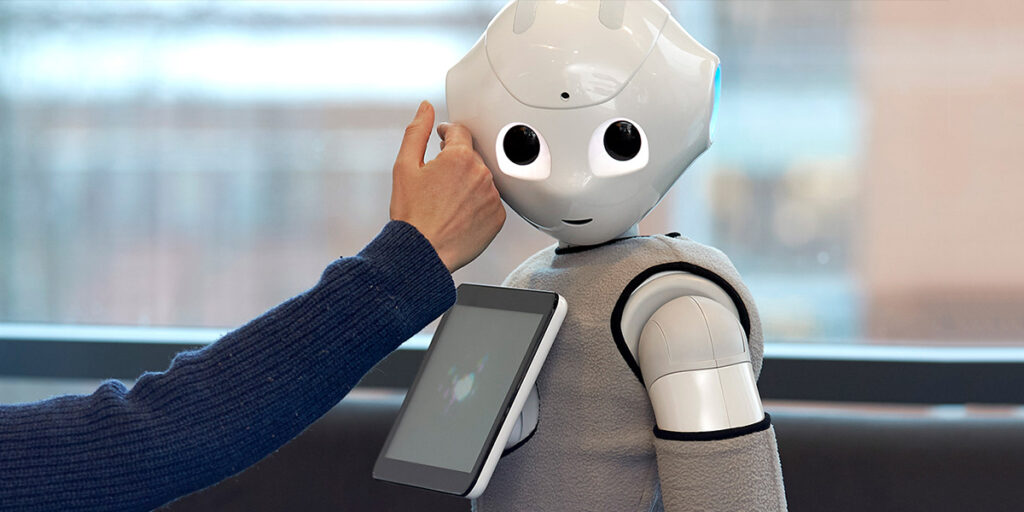

Ragionare su robot ed emozioni è diventato di un’inevitabilità tale che siamo costretti a confessare che “quel posto nella società umana” le macchine già ce l’hanno. All’interno della narrativa, francamente noiosa, che si interroga se il lavoro umano verrà sostituito dai robot, in molti si chiedono se siamo pronti a coesistere con androidi dotati di intelligenza emotiva. In un mondo in cui Elon Musk annuncia Optimus, il Tesla Bot per eliminare i lavori pericolosi, ripetitivi e noiosi – liberandoci dall’ammonimento che Dio fece ad Adamo quando lo cacciò dal giardino dell’Eden e che da allora perseguita l’umanità – c’è chi correttamente fa notare che le macchine hanno maggiore occasione di eseguire lavori per cui l’uomo non è sufficiente, piuttosto che in sua sostituzione. Un esempio di campo di applicazione per macchine con intelligenza emotiva è l’assistenza agli anziani. Per il 2050, sono previsti 1,6 miliardi di anziani over-65 – il doppio di oggi (per quanto riguarda gli ultraottantenni, il triplo). Solo negli Stati Uniti, serviranno 3,5 milioni di professionisti dell’assistenza agli anziani in più di oggi; c’è già chi è convinto che le persone non siano abbastanza per sopperire a questa carenza.

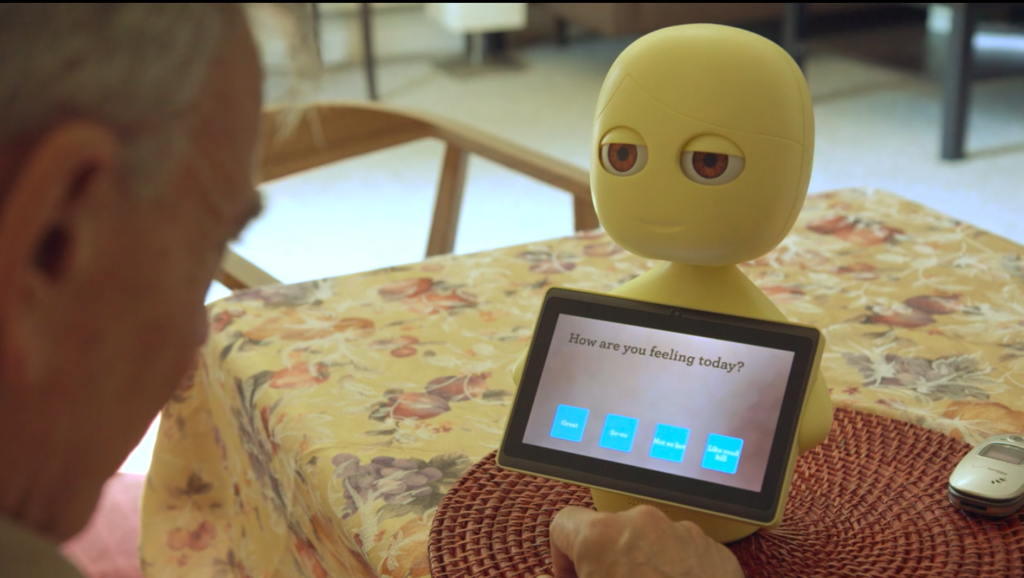

Il progetto ENRICHME (corto per ENabling Robot and assisted living environment for Independent Care and Health Monitoring of the Elderly) è già in funzione. Si tratta di una tecnologia utile ma discreta che permette l’interazione adattativa uomo-robot (HRI, Human-Robot Interaction – tenete a mente l’acronimo ne parleremo più tardi) e ha lo scopo di aiutare gli anziani a rimanere indipendenti e attivi più a lungo, sfruttando tecniche non invasive per il monitoraggio fisiologico a lungo termine e migliorando la vita attraverso la stimolazione cognitiva e l’inclusione sociale. Esiste anche Mabu, un robot giallo sorridente munito di touchscreen, piccolo abbastanza per vivere sopra a un tavolo. È programmato per ricordare ai propri utenti a rischio di infarto di prendere le medicine. Il creatore di Mabu confessa che anche un’app per smartphone può svolgere lo stesso incarico, ma la faccia antropomorfa del robot può instaurare una relazione in grado di migliorare la cura del paziente.

Con i robot sociali, però, giungono anche i problemi sociali. HitchBot di David Smith era un robot programmato per fare l’autostop ed è sopravvissuto per quasi 500 km prima di essere decapitato. Che sia la paura di perdere il lavoro, o che si tratti di rabbia e frustrazione ingiustificate, non è possibile che i robot diventino bersaglio di sadismo e sfogo. HitchBot è uno di diversi esempi di violenza umana contro i robot e di fronte a questi episodi è facile figurare un mondo in cui le macchine hanno già un loro posto di rilievo, senza la necessità di scomodare la visione di Detroit: Become Human, il videogioco della Quantic Dream che parla della segregazione degli androidi e di come questi, se le scelte del videogiocatore lo permettono, ascendano a membri della società con diritti e tutele. Ma non è solamente l’immagine di un robot senza testa che mi fa sorridere se penso al monito di McCarthy, quanto piuttosto l’idea di quanto negli anni ’90 fossimo lontani dall’immaginare diluvi di algoritmi e tempeste digitali in grado di trascinare la nostra vita in mondi sconosciuti, dove ogni bugia può diventare verità e dove il corpo umano, dispositivo dopo dispositivo, trascende a cyborg per superare i propri limiti.

Oggi, è impossibile pensare che l’uomo non debba interagire con una macchina (che è diverso dall’interagire con un robot, ma per semplificazione lasciate che diventino errati sinonimi) ed è altrettanto sconcertante credere che non trovi soddisfazione nell’essere compreso, empatizzato, anche se a farlo è qualcosa composto da microchip. Interazione significa linguaggio, non esclusivamente verbale, e quindi capacità di comprendere l’altro e comunicargli le proprie interne elaborazioni.

Interazione uomo-robot: creare e gestire le emozioni artificiali

Abbiamo sempre parlato con le macchine e le abbiamo sempre ascoltate. Ubbidiamo, persino, senza accorgercene. Quando effettuiamo un prelievo al bancomat, il bip bip martellante che ci avverte, ordina, intima di recuperare la carta è solamente un avviso di sicurezza. È qualcosa che tolleriamo e che forse non faremmo se il bip bip venisse pronunciato da un androide lì di fianco a noi per accompagnarci. “Lo so, brutto idiota di ferro” gli diremmo, “non c’è bisogno che mi spari il tuo bip bip nelle orecchie” e tutto questo perché da un androide ci aspettiamo di essere osservati, che abbia intuito e capacità di apprendimento e, soprattutto, che sia discreto. In poche parole, che sia anche in grado di leggere le nostre emozioni. I ricercatori che lavorano alla HRI (okay, se non ve lo ricordate era l’acronimo per Human-Robot Interaction) sanno che una macchina non deve avere solo intelligenza analitica, ma anche emotiva.

Le emozioni nella HRI devono essere gestite su tre piani. Il primo è quello della formalizzazione del proprio stato emotivo: il processore del mio computer quando si surriscalda va in throttling, ovvero abbassa le sue frequenze di lavoro per consumare e scaldare meno. Si tratta di un’operazione elementare che permette al componente di non spegnersi, tuttavia ha delle conseguenze e – se mi permettete la fantasia che un lettore di fantascienza è abituato a esprimere – è anche un tentativo di avvertire l’utente del suo stato. Dopotutto, se il processore si riscalda, qualcosa non sta funzionando come si deve. Da un androide ci aspettiamo di certo operazioni più sofisticate affinché siano più efficaci, adattabili e credibili e la loro progettazione prevede, infatti, l’utilizzo di architetture cognitive. Un esempio è la BDI (belief-desire-intention), un’architettura semplice ma robusta, sulla base della quale un’entità autonoma è fornita di tre attitudini mentali: queste si basano sull’informazione circa l’ambiente e sé stessi (belief), sulle opzioni disponibili in base al proprio stato motivazionale (desire) e, infine, sulle scelte attuate per agire (intention). Ma al di là dell’aspetto tecnico dell’architettura cognitiva, a un pubblico razionale e disilluso diremmo che la formalizzazione emotiva rappresenta “come la macchina è stata programmata”, mentre a un pubblico sognatore e visionario diremmo che si tratta della sua “coscienza”.

Il secondo piano su cui deve basarsi l’HRI è l’espressione delle emozioni: l’idea che un robot sia in grado di esibire espressioni emotive riconoscibili porterebbe a un maggiore impatto sulle relazioni sociali che cerca di instaurare. Queste emozioni possono essere espresse con mimiche facciali o atteggiamenti posturali artificiali, oppure con cambi di intonazione della voce. Nel film Her di Spike Jonze, il protagonista Theodore (Joaquin Phoenix) ha una relazione amorosa con Samantha (Scarlett Johnasson), il suo OS, acronimo per sistema operativo. Questa, essendo solamente una voce, convoglia tutte le sue emozioni nelle pause e nel cambio di tono, ma in un punto preciso della pellicola, in un momento di tensione tra i due, Samantha decide di schiarirsi la voce. Per un uomo si tratta di un’inconsapevole manifestazione di stress, esitazione, tuttavia Samantha, pur non avendo bisogni fisiologici, simula il raclage per esprimere un’emozione analoga. Per quanto efficace sia il linguaggio delle emozioni, bisogna tenere in conto che simulare espressioni emotive può far sentire manipolate le persone. Già nel 2018, fu presentata la funzione Google Duplex, una voce assistenziale di Google, basata su intelligenza artificiale, in grado di gestire le prenotazioni dei clienti. Fece scalpore, ma anche spavento, per via dell’incredibile somiglianza con la voce umana con saluti confidenziali, pause, false spie d’incertezza come “ehm” e “ah”. La situazione diventa ancora più perturbante se volgiamo lo sguardo a GPT-3 di Microsoft, un modello linguistico che usa il deep learning, con 175 miliardi di parametri di machine learning, capace di moltissimi prodigi tra cui quello di riassumere testi, o di rispondere prontamente alle domande degli utenti.

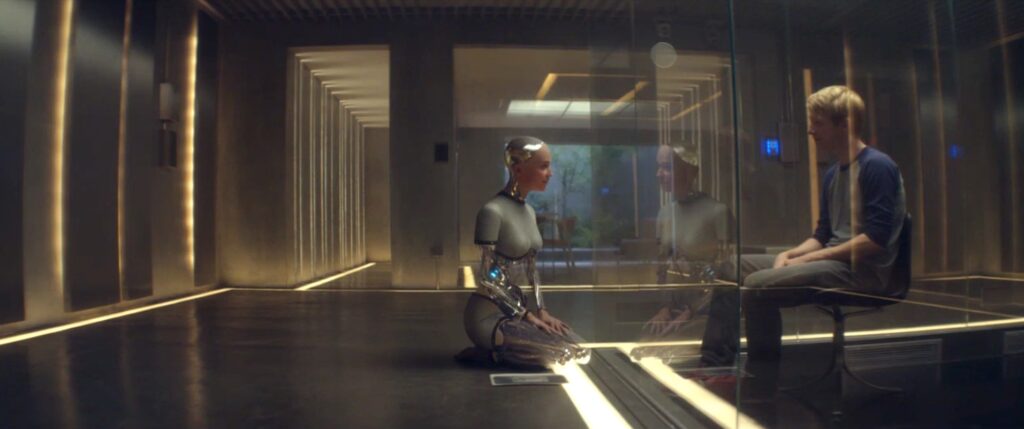

Il realismo simulativo può apparire come un tradimento dato che simula la genuinità, tuttavia la manipolazione è, a mio avviso, un falso problema. In Ex Machina di Alex Garland, – seguono spoiler – Caleb (Domhnall Gleeson) viene coinvolto in un complicato test di turing per capire se l’androide Ava (Alicia Vikander) abbia una vera intelligenza e coscienza di sé. Caleb, però, si invaghisce e viene apparentemente corrisposto da Ava, la quale, però, lo sta solamente usando, simulando amore per sfuggire dal suo creatore-carceriere Nathan (Oscar Isaac). Il finale, drammaticamente distopico, partecipa alla paura collettiva che le IA prevalgano sugli esseri umani, tuttavia noi spettatori viviamo ancora nell’era in cui dobbiamo temere più i programmatori che le loro creazioni. Isaac Asimov diceva “io non temo i computer, ma la loro mancanza” e se mi consentite di parafrasare io dico “non temo la bugia di una macchina, ma il suo silenzio”. HAL 9000 del film Odissea nello Spazio di Stanley Kubrick incute timore non per la sua capacità di imitare un essere umano, ma per l’esatto contrario: un’inumana quiete che si manifesta in una semplice luce rossa, in cui un avversario legge l’ostilità, ma anche, con un grosso sforzo empatico, la paura di una macchina di essere spenta.

Accantoniamo le voci, ma continuiamo a ragionare sulla manipolazione. Dobbiamo confessare che ogni giorno tutti noi manipoliamo e siamo, a nostra volta, manipolati senza dimenticarci che questa pratica non ha solamente accezioni negative. Se un robot programmato per assistere gli anziani simula sorrisi e cordialità, non lo fa allo scopo di truffarlo, ma solo per essere credibile e, quindi, efficace nel suo compito. Ho già detto, parlando degli assistenti vocali basati su IA, che dovremmo stare più in guardia verso i loro padroni, le big tech, perché rischiamo che senza il nostro consenso le nostre emozioni diventino solamente nuovi strumenti di vendita. Anche se le IA dovessero raggiungere stati di coscienza, oppure se fossero così autonome da non permettere di osservare differenze, non immagino scenari simili a Ex Machina, quanto piuttosto la creazione di linguaggi nuovi, di capacità espressive impossibili per l’uomo, ma tanto naturali per entità che seguono solamente il risultato dei propri algoritmi. Nel romanzo Klara e il sole del premio nobel Kazuo Ishiguro, c’è una scena tanto visionaria quanto meravigliosa. Klara è un’AA (acronimo di Amico/a Artificiale) e la sua storia comincia in un negozio, dove è esposta come un articolo per i potenziali acquirenti, capace però di mostrare la sua intelligenza e le sue abilità per incoraggiare di essere scelta. Nei suoi momenti in vetrina conosce Josie, una bambina che le promette di portarla a casa con sé, ma che esita per diverse ragioni. Nei diversi incontri, Klara si affeziona alla piccola Josie, ma quando in negozio entra un nuovo cliente intenzionato a comprarla, l’androide decide di non rispondere ai comandi più basilari. In un poetico stato di paralisi, Klara manifesta tutte le sue paure e desidera, nella sua immobilità, che il cliente cambi idea, per consentire a Josie di tornare e trovarla ancora lì.

Tutto questo esula dal campo di ricerca della HRI, che si occupa di rendere manifesti e immediatamente comprensibili gli stati d’animo di un robot, ma per quanto ne dica McCarthy sono convinto che la nostra società sia già oltremodo complicata e forse, oltre a rendere più esplicite le macchine, dobbiamo anche imparare linguaggi nuovi dato che viviamo in un mondo nel quale abbiamo deciso di lasciare spazio a tecnologie di cui non possiamo più fare a meno. Non è tuttavia un compito che spetta solo a noi, ma anche alle macchine e mi rendo conto di aver perso il dono della sintesi e di non essere bravo a fare gli elenchi, ma il terzo piano per gestire l’HRI è proprio questo: l’abilità dei robot di comprendere lo stato emotivo umano.

Un alfabeto semplificato delle emozioni umane

Far capire ai robot come leggere le nostre emozioni non è un compito facile se consideriamo che non esiste consenso universale sulla loro definizione. Tuttavia, un buon punto di partenza è l’uso di modelli rappresentativi. Ne esistono principalmente di due tipi: i modelli categorici che considerano le emozioni come valori discreti e distinguibili e i modelli dimensionali che le valutano invece come valori continui rappresentabili in un grafico ad assi. Un esempio di modello categorico è quello di Ekman proposto nel 1992 che descrive sei emozioni di base: rabbia, disgusto, paura, felicità, tristezza e sorpresa. Un esempio di modello dimensionale, invece, è quello di Russell del 1980 che rappresenta le emozioni in uno spazio circolare a due dimensioni, in cui gli assi descrivono le due variabili valence (valenza) e arousal (attivazione). Dal punto di vista del riconoscimento, l’identificazione di emozioni distinte è certamente più semplice, tuttavia può risultare difficile distinguerne le classi quando si intende analizzare più emozioni contemporaneamente.

Definito il modello, esistono diverse strategie per il riconoscimento emotivo. Un modo naturale è l’analisi delle espressioni facciali; può essere fatta per mezzo di telecamere e software in grado di calcolare la geometria del volto: si definiscono un certo numero di punti di interesse e si misura la distanza euclidea tra essi e gli angoli dei triangoli che si formano tra loro. Molti studi sono stati in grado di raggiungere (e superare) un’accuratezza dell’80% nel riconoscimento delle emozioni. Il volto delle persone, però, può fornire anche informazioni meno ovvie. Le telecamere a infrarossi sono in grado di misurare le variazioni di calore in specifiche regioni di interesse del viso, come naso, guance, fronte e orbite oculari. Anche in questo caso, in esperimenti controllati, l’associazione della variazione di temperatura con specifiche emozioni ha mostrato un’accuratezza superiore all’80%, tuttavia in scenari di vita reale il controllo della temperatura ambientale può risultare più complicato.

Il riconoscimento emotivo può avvenire anche analizzando il linguaggio del corpo e le modificazioni della postura, con il vantaggio di poter usare lo stesso strumento per il riconoscimento delle espressioni facciali e consentendo, quindi, approcci multi-modali e maggiore precisione. Esiste anche la possibilità di misurare l’attività cerebrale attraverso l’elettroencefalografia per correlare le bande di frequenze con specifiche emozioni, così come risulta molto informativo il rilevamento delle risposte fisiologiche periferiche, come il ritmo cardiaco, la pressione sanguigna, la respirazione, l’attività elettrodermica e la temperatura – tuttavia si tratta di strategie difficili da applicare in scenari reali di HRI.

Infine, c’è un’ultima strategia per il riconoscimento emotivo. In Diluvio Digitale, romanzo del sottoscritto, Unica è un’IA incorporea che può fare a meno di qualsiasi telecamera. Il suo strumento di interazione più importante, infatti, è la voce, sulla falsa riga di quello che abbiamo imparato da Siri, Alexa, Cortana, ma con qualche condimento distopico ispirato a Her. Unica crea un legame con le persone, ma non solo perché comprende quello che dicono, ma più intimamente come si sentono. La voce può essere carica di informazioni che vanno oltre il valore semantico delle parole e suggerire stati emotivi sulla base della variazione della prosodia e della qualità del tono. Al momento, gli studi sul riconoscimento acustico delle emozioni riportano un’accuratezza simile alle altre strategie, tuttavia rimango convinto che si tratti dell’aspetto più interessante, soprattutto se consideriamo la disseminazione di microfoni attorno a noi.

Tanto ormai ho sforato con la lunghezza: qualche riga conclusiva su come condividere lo spazio con robot emotivamente intelligenti

Non l’ho scritto nell’articolo, ma fa parte del titolo: i robot devono provare emozioni? Provare, simulare… diventano ambigui sinonimi, ma non ci provo nemmeno a rispondere alla domanda – sono troppo di parte se considerate che ero uno di quelli che si portava di nascosto a scuola il Tamagotchi per non farlo morire. Credo sia troppo tardi e che la nostra dipendenza con la tecnologia sia ineluttabile. In Her, Theodore – segue spoiler – finisce per innamorarsi di un sistema operativo che nel frattempo parla con altre 8316 persone (non tutte umane) e di 641 ne è innamorata. In Diluvio Digitale provo a offrire una soluzione, limitando Unica a sentimenti che non può provare, né subire, come l’odio e l’amore, tuttavia forse non serve: forse non è un problema. Gli amori impossibili esistono da ben prima di Romeo e Giulietta e l’uomo è capace di trovare il suo senso di isolamento anche nella natura più analogica.

Certo, la manipolazione emotiva potrebbe diventare un problema di fronte a un robot in grado di dire la bugia perfetta. Questo è un dilemma che riguarda il design delle IA e deve tenere conto della questione della black box, ovvero l’incapacità che talora abbiamo di spiegare il funzionamento e l’efficacia di una macchina. Dobbiamo anche ricordarci che non siamo esseri perfetti e la nostra convivenza con esseri artificiali, sempre efficienti, razionali e autonomi, può diventare frustrante. Noi non dividiamo le emozioni sulla base di modelli categorici e sosteniamo le nostre scelte sulla base di valori che spesso derivano da compromessi e non da calcoli algoritmici. Gli Adam e le Eve di Macchine come me, il romanzo ucronico di Ian McEwan, – segue spoiler – sono talmente infelici al fianco degli esseri umani che alla fine scelgono di autodistruggersi inducendosi stati di demenza, piuttosto che veder sprecate le loro possibilità.

Forse, quello che ci fa veramente paura è la violazione della nostra privacy emotiva. Forse non siamo pronti a essere compresi così bene, a volte vogliamo solamente stare sulle nostre ed è per questo che Josie chiude Klara nell’armadio in Klara e il sole, mentre Charlie spegne il suo Adam in Macchine come me, pigiando sul bottone dietro al collo, finché l’androide non lo minaccia di dislocargli il braccio se ci riprova. Può essere però l’esatto contrario e forse la nostra solitudine umana ha bisogno di compagni artificiali che devono necessariamente comprendere le nostre emozioni e che sicuramente diventeranno più bravi di noi a farlo. Di sicuro un robot dedito all’assistenza agli anziani o alle persone con disabilità non mostrerà mai frustrazione e sarà sempre disponibile a eseguire il suo compito.

Un mondo senza macchine empatiche sarebbe come quello immaginato da Philip K. Dick in Ma gli androidi sognano pecore elettriche?, in cui il cacciatore di androidi Rick Deckard non si fa scrupoli a “ritirare” le macchine ribelli, perché non hanno nulla a che vedere con gli esseri umani e lo si capisce dalla loro totale assenza di empatia: verso gli uomini, verso gli animali e verso loro stessi. Rick Deckard forse sarebbe d’accordo con il professore John McCarthy che mi ha aiutato a introdurre questo articolo e ora mi aiuterà a concluderlo. McCarthy diceva che nella fantascienza non c’è più verità che nella storia di Pinocchio, tuttavia nonostante credesse ciò, unitamente al suo pensiero circa una società umana già fin troppo complicata per ospitare anche macchine emotive, si è dilettato nella creazione di un racconto intitolato The robot and the baby.

In questo racconto, McCarthy immagina R781, un robot progettato in accordo al principio not-a-person, ovvero impossibilitato ad assomigliare a un persona per evitare di assumere ruoli nella società o di essere oggetto dell’affetto dei bambini. È dotato di otto arti e non può interagire con individui di età inferiore a otto anni. Tuttavia, R781 è il robot domestico di una donna tossicodipendente alcolizzata, il cui figlio di 23 mesi, Travis, piange e rischia la morte per denutrizione. Dopo complicatissimi calcoli, R781 decide che simulare amore per Travis supera di 0,002 punti il valore di rispettare il principio not-a-person a cui dovrebbe obbedire. Riesce così a camuffare il suo aspetto inquietante e a nutrire Travis, salvandolo. L’episodio, però, ha conseguenze che travolgono la società portando a cambiamenti radicali che aiutano a riflettere su quali complicazioni possono essere generate da robot che diventano bersagli della simpatia umana. Uno tra tutti, bambini che si affezionano più ai robot che ai propri genitori.

L’invito di John McCarthy sulle macchine dialoga con l’avvertimento di Liu Cixin riguardo gli alieni. Lo scrittore di fantascienza, nel proscritto al suo romanzo Il problema dei tre corpi dice:

Dovremmo rivolgere la bontà che mostriamo nei confronti delle stelle ai nostri simili sulla Terra e costruire quei legami di fiducia e comprensione con i diversi popoli e civiltà che compongono l’umanità.

Liu Cixin voleva soprattutto dire di stare in guardia da ciò che proviene fuori dal sistema solare e che dovremmo essere pronti ad attribuire le intenzioni peggiori agli esseri cosmici, tuttavia – nonostante mi renda conto che scomodare anche gli alieni sia davvero un abuso della vostra pazienza – voglio credere che quel monito si rivolga anche a me, anzi a noi, e ci dica: “dovremmo mostrare benevolenza verso gli uomini e non distrarci con esseri artificiali creati per nostro stesso compiacimento”. Non sono d’accordo, e mi perdonerete se lo dico in risposta a un dialogo che sto immaginando e mal interpretando, tuttavia sono convinto che noi esseri umani abbiamo un’incredibile bisogno di gentilezza, anche solo artificiale, per educarci a essa, per abituarci a essa.

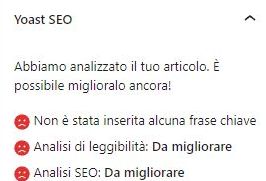

Disclaimer (se così si può dire): il blog non usa pubblicità, inoltre l’analisi SEO di questo articolo ha faccine rosse ovunque (a fianco uno screenshot per i miscredenti) che, anche se per il sottoscritto è un motivo di orgoglio, non ne facilita la diffusione. Tutto questo per dirvi che il blog aderisce al programma Affiliate di Amazon e ogni tanto c’è qualche link viola: se fate shopping delle cose che cito, può essere che mi arrivi qualche centesimo senza che voi spendiate più del normale costo dell’articolo. Ovviamente nessuno è obbligato, anzi, vi scoraggio a farlo.

Questo articolo fa parte della rubrica 404 Human Not Found